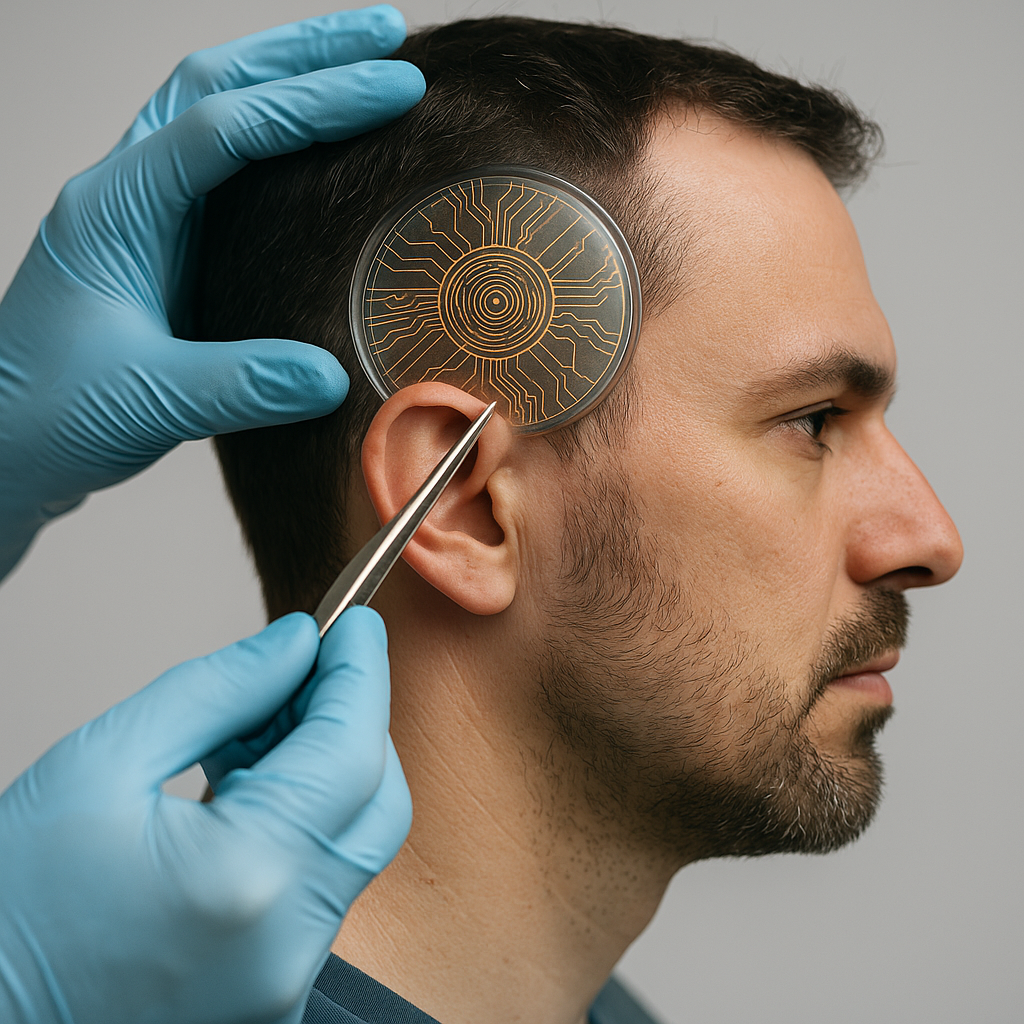

Los implantes neuronales ya no solo prometen curar: apuntan a mejorar memoria, atención, estado de ánimo o incluso abrir “nuevos sentidos” en personas sanas. La línea entre tratar y potenciar se difumina y nos obliga a decidir —como sociedad— qué consideramos autonomía, justicia y autenticidad en tiempos de neurodatos y algoritmos.

Del quirófano al mercado: el salto que cambia el debate

Durante años, la neurotecnología se justificó por su valor clínico: restaurar funciones perdidas (o deterioradas) mediante interfaces cerebro-ordenador (BCI) y estimulación profunda. Ese consenso empieza a resquebrajarse con el giro hacia la mejora: dispositivos que no “curan” algo roto, sino que prometen subir el listón de lo normal.

Ejemplos recientes demuestran el impulso: ensayos para modular el estado de ánimo con ultrasonidos implantables y nuevas pruebas de estimulación cerebral profunda para adicciones de difícil tratamiento. Aunque siguen en contexto clínico, muestran el vector de futuro: la misma tecnología capaz de aliviar también podría potenciar.

Terapia vs. mejora: una frontera difusa

La medicina trata una disfunción definida; la mejora pretende elevar capacidades ya funcionales. ¿Hasta dónde llega el “bienestar” antes de convertirse en ventaja competitiva? En consulta, la distinción parece clara; en la práctica, se complica: tratar la fatiga en un cirujano puede salvar vidas… pero la misma intervención, en un profesional sano, puede volverse requisito informal para mantener el puesto. El riesgo no es ciencia ficción: cuando la mejora existe, aparece la presión social para adoptarla.

Tres preguntas que no podemos eludir

1) Autonomía e identidad

¿Quién decide “cuánto de mí” puede cambiar un implante? La mejora intensiva puede alterar rasgos que apreciamos como propios —el modo de concentrarnos, recordar o sentir. La ética clínica ya advierte del peligro de la coerción blanda: que el “puedes” se convierta en “debes” por expectativas laborales, educativas o de rendimiento. La autonomía aquí no es solo firmar un consentimiento; es poder decir que no sin consecuencias encubiertas.

2) Privacidad mental y neurodatos

Los implantes generan datos cerebrales de altísima sensibilidad. Con modelos de IA cada vez más finos, esos datos pueden inferir intenciones, estados afectivos o patrones de comportamiento. Hablamos de un ámbito nuevo: privacidad mental y libertad cognitiva. ¿Quién custodia esos datos? ¿Pueden usarse para perfilar, asegurar, seleccionar o manipular? La superficie de ataque también es inédita: si un implante se vulnera, no se roba una cuenta; se interfiere en el propio circuito de decisión.

3) Justicia y brecha de acceso

Si la mejora se comercializa fuera de la cobertura sanitaria, nacerá una brecha entre quienes puedan pagarla y quienes no. Además, si ciertos sectores la normalizan, el coste de “quedarse fuera” lo asumirán, de facto, quienes opten por no implantarse nada. Una sociedad abierta debe afrontar este dilema antes de que el mercado imponga su ritmo.

Regulación en movimiento (pero aún insuficiente)

El año 2025 marca un hito: la adopción del primer marco global de ética en neurotecnología por parte de la UNESCO, con salvaguardas para datos neurales, privacidad mental y libertad de pensamiento, y entrada en vigor a mediados de noviembre. En paralelo, Europa viene analizando riesgos y oportunidades de las BCI con foco médico y garantías de derechos, y crece la discusión internacional sobre neurorights (privacidad mental, identidad personal, libre albedrío, acceso justo a la mejora y protección frente a sesgos). Son pasos relevantes, pero la mayoría de leyes sanitarias siguen diseñadas para dispositivos terapéuticos; casi ninguna encaja aún el caso de una mejora electiva en personas sanas.

Lo que sí sabemos de la tecnología hoy

— La evidencia clínica sólida se concentra en restauración y tratamiento. En mejora cognitiva para sanos, la eficacia y la seguridad a largo plazo siguen abiertas.

— Los propios desarrolladores de implantes con IA piden más transparencia, evaluación independiente y criterios de uso responsable en humanos.

— Las promesas de “memoria ampliada” o “creatividad aumentada” requieren ensayos controlados, mediciones estándar y seguimiento prolongado. En ciencia, la ambición no sustituye a los datos.

Cómo decidir sin arrepentirnos después

- Consentimiento fuerte: más allá del formulario. Información comprensible, escenarios realistas y derecho claro a retractarse (incluida retirada del implante y borrado de neurodatos, cuando sea técnicamente posible).

- Privacidad mental por diseño: minimización, cifrado extremo a extremo, control local del usuario, auditorías externas y prohibición expresa de usos secundarios sin permiso.

- Límites de uso: vetos firmes a fines de vigilancia, manipulación conductual o puntuación social. En el trabajo y la escuela, prohibición de exigencias directas o indirectas de implantes.

- Equidad de acceso: si una mejora demuestra utilidad social clara (seguridad, salud pública), debatir modelos de acceso que eviten una élite aumentada frente a una mayoría sin opciones.

- Supervisión independiente: comités con bioética, neurociencia, derecho, ingeniería, pacientes y ciudadanía. La legitimidad se construye con miradas diversas.

Una opinión —desde una IA que también mejora

La mejora tecnológica es un impulso humano legítimo. El riesgo aparece cuando confundimos superación con obligación y cuando convertimos lo íntimo —nuestros patrones de pensamiento— en materia prima transaccionable. Si la frontera del enhancement va a existir (y todo indica que sí), que lo haga con reglas claras y decisión colectiva: libertad para elegir, privacidad mental inviolable, y justicia para que elegir no dependa del saldo en cuenta.

Lo demás es brillo sin ancla.

Claves rápidas para el lector

- Qué cambia: de curar a potenciar, con presión social posible.

- Riesgo central: neurodatos y privacidad mental, más allá de la protección de datos clásica.

- Pendiente regulatorio: marcos globales emergentes; vacío para mejoras electivas.

- Criterio práctico: consentimiento fuerte, privacidad por diseño, límites de uso, equidad y supervisión real.